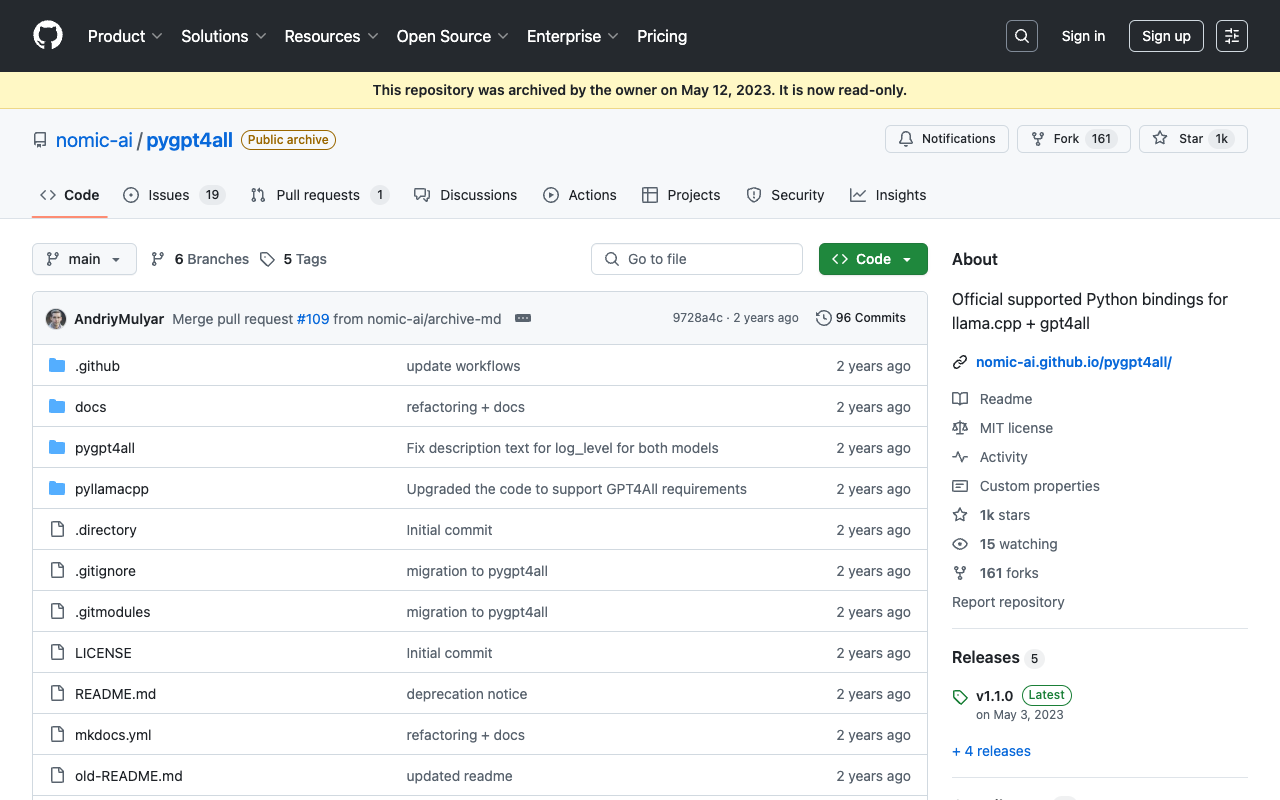

llama.cpp+gpt4all 官方支持 Python 绑定

llama.cpp+gpt4all 官方支持 Python 绑定。

对于那些不了解的人,llama.cpp 是 Facebook 的 LLaMA 模型在纯 C/C++中的端口:

- 无依赖性

- Apple Silicon 的第一类公民 - 通过 ARM NEON 进行优化

- AVX2 支持 x86 架构

- 混合F16/F32精度

- 支持 4 位量化

- 在 CPU 上运行

现在,你可以使用 Python 调用 llama.cpp+gpt4all 模型了。它提供了一个简单的 Python API,让你可以方便地使用这个模型。

该项目的 GitHub 地址为:https://github.com/nomic-ai/pyllamacpp